Houd toch op met die kroketevaluatie! Dat was grof gezegd de reactie van enkele L&D’ers op mijn blog over evalueren. Guus van Deelen schreef er een artikel over en vroeg me daarop te reageren om het vak verder te helpen. Dat doe ik graag, want trainen en L&D lijken wel twee verschillende werelden, terwijl we veel aan elkaar kunnen hebben. Spoiler alert: Guus en ik zijn het niet eens, maar juist de uitwisseling van argumenten kan een voedingsbodem zijn voor verbetering.

Wil je eerst de voorgaande stukken lezen?

- Mijn blog over evalueren vind je hier.

- De reacties van L&D’ers op LinkedIn vind je hier.

- Het artikel van Guus vind je hier.

Wat is er mis met de kroketevaluatie?

Samengevat schrijft Guus in zijn LinkedIn-artikel het volgende.

1.

Een ‘kroketevaluatie’ is zinloos. Als je deelnemers vraagt om een training te beoordelen met cijfers, hangen die cijfers niet samen met de leeropbrengsten. Hoge cijfers betekenen dus niet dat de deelnemers veel leren en lage cijfers betekenen niet dat ze weinig leren. Hoge cijfers hangen wel samen met de vooroordelen die studenten of deelnemers hebben. Zo geven ze mannelijke trainers of docenten steevast hogere cijfers dan vrouwelijke trainers of docenten.

2.

Leeropbrengsten hangen dus niet samen met een ‘kroketevaluatie’, maar wel met het didactisch handelen van trainers en docenten. Studenten en deelnemers leren meer als hun docenten en trainers goed les of training geven.

3.

Als je wilt evalueren op een manier die bijdraagt aan betere leeropbrengsten stel je deelnemers dus vragen over het didactische handelen van docenten of trainers. Guus Deelen laat zich daarbij inspireren door Will Thalheimer en stelt deelnemers vragen als:

- Gaf de trainer realistische voorbeelden?

- Kreeg je feedback van de trainer?

- Gaf de trainer voldoende gelegenheid tot oefenen?

- Stelde de trainer vragen?

- Voelde je je veilig bij de trainer?

4.

Als docenten of trainers onvoldoende scoren op deze vragen kunnen ze actie ondernemen. Ze weten waar de pijn zit en kunnen meteen aan de slag: meer voorbeelden toevoegen, meer feedback geven, meer vragen stellen enzovoort.

5.

Deze manier van evalueren draagt wel bij aan betere leerresultaten en is daarmee beter dan een evaluatie waarin je deelnemers en studenten vraagt om cijfers te geven aan trainers of docenten. Zulke ‘kroketevaluaties’ kun je dus beter afschaffen.

Guus vroeg me om te reageren op zijn artikel om zo het vak verder te helpen. Bij dezen: hieronder reageer ik punt voor punt op zijn betoog.

Eens met punt 1 en 2

Met de eerste twee punten van Guus ben ik het volmondig eens. Het klopt dat schriftelijke evaluaties van training door deelnemers weinig zeggen over leeropbrengsten. Het klopt ook dat goed didactisch handelen van een trainer wel samenhangt met de leeropbrengsten. Een training die goed is opgezet en goed wordt begeleid leidt tot veel hoger rendement dan een training die minder goed is opgezet en begeleid wordt. In ons nieuwe boek Evidence based trainen geven we daar tientallen voorbeelden van.

Punt 3: deelnemers zien het handelen van trainers niet goed

Samen leiden de eerste twee punten tot het derde: laat deelnemers het didactisch handelen van trainers beoordelen met gerichte vragen. Dat lijkt een slimme manier, want deelnemers zien de trainer tenslotte de hele tijd trainen.

Maar in de praktijk zal dat tegenvallen. Want deelnemers aan een training zijn helemaal niet bezig met het gedrag van hun trainer. Ze zijn vooral bezig met hun eigen leerproces en 90 procent van wat de trainer doet valt ze niet op. Vergelijk het met een bezoek aan de huisarts. Tijdens een spreekuur ben je als patiënt meestal niet bezig met de vraag of die haar gesprek goed opbouwt, de juiste vragen stelt en tot een afgewogen diagnose komt. Je merkt vooral of de arts vriendelijk is en of je haar advies begrijpt.

Met deelnemers aan een training is het niet anders. Dat merk ik elke keer weer in mijn rol als opleider van trainers. Het komt vaak voor dat ik mijn deelnemers een bepaalde trainingstechniek leer en die even later zelf gebruik. Je zou verwachten dat alle deelnemers dat meteen doorhebben, maar dat is niet zo. Meestal is er wel één die zegt ‘Hier doe je wat je zojuist uitlegde’, maar de anderen was dat niet opgevallen. En dat is niet gek, want deelnemers zitten in de training voor hun eigen leerproces, niet om de trainer te beoordelen.

Kortom, wanneer je deelnemers vraagt om het didactisch handelen van de docent of trainer te evalueren, zul je veel uitkomsten krijgen die niet erg kloppen.

Punt 4: je laat trainers in de kou staan

En dan het vierde punt: met de resultaten van de evaluatie kunnen trainers en docenten hun eigen handelen verbeteren. Want wanneer je als trainer feedback krijgt dat je te weinig voorbeelden geeft, voeg je meer voorbeelden toe. En wanneer de feedback luidt dat je te weinig vragen stelt, ga je meer vragen stellen.

Maar daarmee onderschat je wat er allemaal nodig is om goed didactisch te handelen. Het is nog niet zo eenvoudig om goede feedback te geven. Dat vereist dat je heel helder hebt waarop je feedback moet geven en hoe je dat doet: vertel je wat deelnemers fout deden, vertel je hoe ze het beter kunnen doen, geef je een compliment op wat ze nu al goed doen? En het is nog niet zo gemakkelijk om voorbeelden te geven, want daarvoor moet je de praktijk van de deelnemers door en door kennen. Bovendien heb je een praktijkgerichte opbouw van je training nodig, terwijl veel trainingen opgebouwd zijn vanuit theoretische modellen. Die hele structuur moet op zijn kop, willen de trainers hun didactisch handelen echt verbeteren.

Kortom, de vragen die Guus de deelnemers wil voorleggen spreken niet voor zich, maar vormen het puntje van een ijsberg. In een goede training zitten inderdaad realistische voorbeelden, laat de trainer iedereen oefenen en krijgen alle deelnemers feedback. Maar vanuit die ‘puntjes van de ijsberg’ terug redeneren hoe je een training beter maakt is hartstikke lastig. Als trainers weten dat je iets fout doet, betekent nog niet dat je automatisch weet hoe het beter kan. Met alleen een kritische evaluatie laat je trainers dus in de kou staan.

Punt 5: weg met de kroketevaluatie?

Tot slot wil Guus en meer L&D’ers met hem af van de ‘kroketevaluatie’ waarin deelnemers cijfers geven aan de training en aan de trainer. Daarmee evalueer je immers alleen of de deelnemers het naar hun zin hebben gehad en niet hoe goed de trainer is en al helemaal niet of de training resultaat heeft.

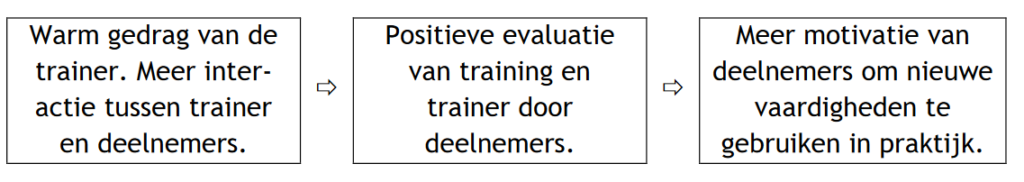

Maar of deelnemers het naar hun zin hebben is het enige waar ze echt expert in zijn: dat kunnen ze als geen ander aangeven. En uit dezelfde meta-analyse waarnaar Guus verwijst in zijn artikel blijkt dat die beleving wel degelijk invloed heeft op de transfer van de training naar de praktijk. Met een positieve beleving van de training zijn de deelnemers namelijk beter gemotiveerd om de kennis en vaardigheden die ze geleerd hebben te gebruiken in de praktijk. Dat verband ziet er als volgt uit.

Warm gedrag van trainers is dus belangrijk en een schriftelijke evaluatie is dé manier om daar feedback op te krijgen. Zie ook het voorbeeld waarmee ik mijn blog over evalueren begon. Ik vertelde over een teleurgestelde reactie van een deelnemer: ‘Ik vond het fijn hoe je reageerde toen ik vertelde dat ik in scheiding lag. En ook hoe je me de vrijheid gaf om de opleiding op eigen tempo te volgen. Maar ik had het wel fijn gevonden als je later nog een keertje had gevraagd hoe het met me ging.’

Deze deelnemer voelde te weinig contact en voelde zich te weinig gezien. Had ze me dat niet verteld, dan was dit altijd een blinde vlek voor me gebleven. Maar doordat ik een kroketevaluatie rondstuurde, kwam dit punt wel op tafel. Ik zal hier een volgende keer nu scherper op zijn.

Conclusie

Alles bij elkaar is een ‘kroketevaluatie’ volgens mij dus nog steeds de moeite waard. Het is waar dat zo’n evaluatie weinig zegt over de leeropbrengsten van een training. Maar ze zegt wel iets over de beleving van de deelnemers en dat is belangrijke informatie die je op een andere manier nauwelijks boven tafel krijgt.

Verder geloof ik niet dat deelnemers vragen om het didactische handelen van trainers te beoordelen zal leiden tot betere trainingen. Want deelnemers letten tijdens een training onvoldoende op het gedrag van hun trainer om daar zinnige uitspraken over te kunnen doen. En zelfs als deelnemers aangeven dat trainers didactisch onder de maat scoren, geeft dat trainers te weinig houvast om het beter te gaan doen.

Tot slot denk ik dat schriftelijke evaluaties – zelfs als ze wel goede informatie zouden geven – een omslachtige manier zijn om de kwaliteit van trainingen te verbeteren. Achteraf evalueren is vooral nuttig als we nog moeten uitdokteren wat een training en trainer effectief maakt. Maar dat weten we allang. De snelste weg naar resultaat is dus om trainers op te leiden in bewezen effectieve interventies. Ook hier is een vergelijking met de gezondheidszorg verhelderend. Want stel je voor dat artsen geen opleiding hoeven volgen voordat ze een praktijk openen, maar meteen aan de slag mogen gaan zolang ze hun handelen maar laten evalueren door patiënten. Vanuit die evaluaties leren ze dan wat ze beter kunnen doen. Op de lange duur zullen ze vast beter worden, maar snel gaat het niet en intussen zijn er veel patiënten die daaronder lijden.

In de gezondheidszorg gaat dat gelukkig anders, maar in de wereld van het trainen gaat het wel vaak zo. Mensen gaan zonder veel opleiding aan de slag als trainer en leren gaandeweg van hun ervaringen. En dat is doodzonde – voor de deelnemers, voor de organisaties die investeren in trainingen en ook voor de trainers zelf.

Verder lezen?

Wil je meer weten over bewezen effectieve interventies voor trainers? In ons nieuwste boek Evidence based trainen beschrijven we er 44 en laten we zien welke onderzoek daarachter schuilgaat.

Zomaar even wat gedachten naar aanleiding van deze blog:

Als wij trainers op basis van wetenschappelijke kennis weten dat veiligheid in de groep belangrijk is voor de effectieve informatieverwerking van de deelnemer is het m.i. wel zinvol om te vragen: ” voelde jij je veilig?”, maar zou dit vervolgd kunnen worden door de vraag ” Zo ja/nee, wat deed ik waardoor jij je (on)veilig voelde?” Zo evalueer je jouw didactisch handelen veel gerichter en sta je als trainer niet in de kou.

De vraag: ” Stelde de trainer vragen?” zou m.i. ook nog beter geformuleerd kunnen worden: “Stelde de trainer vragen waardoor jij ging nadenken?” vervolgd door “Zo ja, kun je een of twee voorbeelden geven?” Zo krijgen we gerichte informatie waarmee wij onze ontwikkeling als trainer bij kunnen sturen.

Ook vind ik het zinvol om enige tijd na afloop van de training een (evt. tweede) evluatieformulier rond te sturen. Juist wanneer je een warme vriendelijke sfeer weet te creeren tijdens de training kan de loyaliteit aan de trainer groot zijn. Dat kan sociaal wenselijk antwoorden in de hand werken. Als je na enige tijd nog eens evalueert, kan tijd en afstand de loyaliteit doen verflauwen, wordt de kans op sociale wenselijkheid kleiner en krijg je wellicht eerlijker antwoorden waar je als trainer echt iets aan hebt. Overigens, sociale wenselijkheid kan ook verminderen wanneer je ook al tijdens een training laat zien dat je iets met de signalen van de deelnemers doet, dus dat je de training voor deze specifieke groep nog beter wil maken dan dat het al is (“Als we op deze manier verder gaan, is dit dan nuttig/leerzaam/ etc. voor jullie?”)

Wanneer ik tijdens een training een didactische interventie doe, die ook tot de leerstof van de training behoort, dan doe ik vaak even een stap opzij (letterlijk) en vraag ik de deelnemers “by the way, wat zagen jullie mij nu net doen?” Zo help je deelnemers naar een metaniveau om vandaaruit jouw gedrag als voorbeeldgedrag te beschouwen. Mijn ervaring is dat deelnemers daar wel even over moeten nadenken (goed!) maar dat ze vrijwel altijd met een antwoord komen.

Ha Karin, dat heb je genuanceerd uitgewerkt. Ik begrijp Guus helemaal, want ik erger me soms ook aan die tevredenheidsevaluaties. Vooral als ik opleiders ontmoet die zeggen: “Onze trainingen scoren gemiddeld een 9 dus ze zijn goed!” Of trainers die zeggen “Ik krijg veel complimenten van mijn deelnemers, dus ik hoef mijn trainingen niet te verbeteren.” Ik ben het ook met jou eens dat je ze niet helemaal hoeft af te schaffen en dat je de tips van Guus (over de vraagstelling) beter niet kunt toepassen. Wat mij betreft om nog een andere reden: als je de vragen concreet genoeg maakt kunnen de deelnemers dit best, maar ik vind het niet professioneel om mijn deelnemers hiermee lastig te vallen. Ze komen voor hun eigen leerproces, niet om mijn professionele gedrag tot in detail te beoordelen.

Nog een aanvulling: het lijkt of in deze discussie ‘evaluatie’ en ‘feedback’ door elkaar heen lopen. En ik snap ook wel dat dit in de praktijk vaak zo werkt. Maar zou je het echt zuiver doen, dan probeer je tijdens de evaluatie zo feitelijk mogelijk te meten. In het geval van de tevredenheidsevaluatie gaat het dan dus om vragen waarmee de tevredenheid van de deelnemers wordt gemeten. Eventuele feedback kan vervolgens helpen om die meetresultaten te duiden of in de toekomst te verbeteren. Maar feedback is niet de enige bron om het resultaat te verbeteren en een trainer hoeft dus ook niet afhankelijk te zijn van die feedback. Helemaal eens met jouw vergelijking met de chirurg.

Belangrijker dan de vraag hoe we die tevredenheidsevaluatie kunnen uitvoeren, is volgens mij hoe we op de hogere niveaus van KirkPatrick onze trainingen kunnen evalueren. Dus blijf die tevredenheidsevaluatie lekker doen, maar ga daarnaast ook evalueren op niveau 2 (leerresultaat) en niveau 3 (gedrag in de praktijk). Uitdagend, maar wel noodzakelijk voor het bestaansrecht van het trainersvak.

Ik gebruik de eind feedback voornamelijk om deelnemers een laatste zetje te geven om aan de slag te gaan met wat ze hebben geleerd. Dus niet zozeer vragen over het leer process maar meer in de trant van “Welk aspect van de training was het nuttigst”, “Welk aspect ga je meteen toepassen” of “Wat is het eerste dat je gaat doen om toe te passen wat je hebt geleerd”. Ook vraag ik wat ze nodig hebben om toe te passen wat ze hebben geleerd, waar ze nog meer begeleiding bij nodig hebben, etc. Deze vragen kunnen ook in een scoring format gesteld worden.

En ja, dan nog een vraag wat ik goed en minder goed deed, en algemene feedback (om lekker te klagen over het eten, de harde bedden, de verbouwing naast de zaal, etc.).

Ik doe de evaluatie in Slido en laat ook meteen de resultaten zien, wat deelnemers over het algemeen erg waarderen. Zo zien ze dat ik hun feedback waardeer en kan ik er ook op terugkomen tijdens een eventueel volgend contact moment.